Tới lượt phó tổng thống Mỹ JD Vance trở thành nạn nhân của deepfake

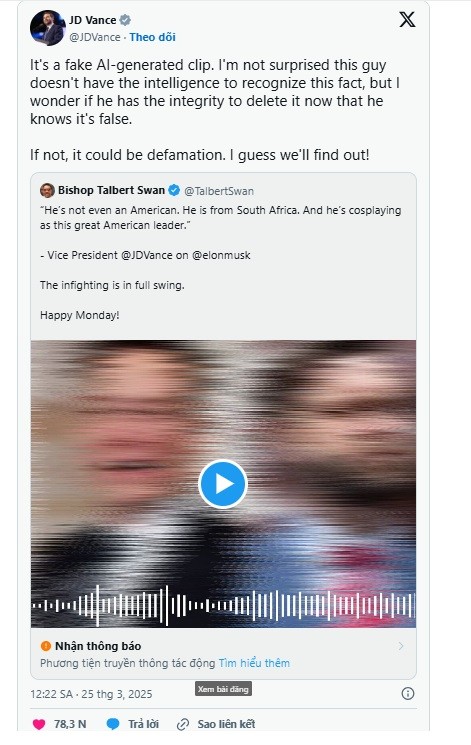

Vào cuối tuần qua, một đoạn ghi âm được lan truyền trên mạng xã hội được cho là phó tổng thống Mỹ JD Vance nói rằng Elon Musk đang “đóng giả làm một nhà lãnh đạo vĩ đại của nước Mỹ”, khiến chính quyền “trông tệ” hơn. Thực chất, đây chỉ là một sản phẩm của deepfake.

Sau khi đoạn ghi âm được lan truyền trên internet, giám đốc truyền thông của Phó Tổng thống Mỹ JD Vance là William Martin đã nói trên X rằng: “Đoạn ghi âm này là giả 100% và chắc chắn không phải là Phó tổng thống”. Bài đăng của Martin đã trích dẫn một bài đăng khác trên X chia sẻ đoạn ghi âm nhưng bài đăng đó đã bị xóa.

Hiện, vẫn chưa rõ phần mềm cụ thể nào được sử dụng để tạo ra âm thanh, nhưng phần mềm của công ty chuyên tạo ra thông tin sai lệch bằng AI và deepfake là Reality Defender đã phát hiện ra âm thanh này “có khả năng là giả”.

“Chúng tôi đã chạy nó qua nhiều mô hình phát hiện âm thanh và phát hiện ra rằng nó có khả năng là giả mạo”, một phát ngôn viên của Reality Defender cho biết trong một tuyên bố. “Tiếng ồn nền và tiếng vang cũng có khả năng được thêm vào để cố tình che giấu chất lượng âm thanh deepfake làm cho nó trở nên chân thực hơn".

Trước khi được người phát ngôn của JD Vance phản ứng với đoạn âm thanh được chia sẻ trên X, có vẻ như đoạn âm thanh này đã được lưu hành trên TikTok. Một video TikTok về đoạn âm thanh này, không được gắn nhãn do AI tạo ra, hiện đã có hơn 2 triệu lượt xem và 8.000 bình luận. Trong các bình luận đáng chú ý có ý kiến cho rằng: "Với sự trỗi dậy của AI, tôi không biết phải tin vào điều gì”.

Theo các chuyên gia, về mặt kỹ thuật, âm thanh nghe được có vẻ khá chân thực. Giọng nói nghe giống hệt với ông Vance, tiếng nhiễu trong âm thanh nghe rất giống với các âm thanh được ghi âm bí mật khác của các chính trị gia đã bị rò rỉ cho các tổ chức tin tức trong quá khứ.

Reality Defender cũng lưu ý, tiếng nhiễu được thêm vào cũng khiến các máy dò deepfake tự động khó nhận ra âm thanh là giả. Âm thanh này cũng đã được đăng lại trên TikTok hàng chục lần, cũng như YouTube và X.

Bất chấp việc TikTok có chính sách chống chia sẻ thông tin sai lệch và yêu cầu người dùng gắn nhãn nội dung do AI tạo ra nhưng các bản sao của đoạn âm thanh deepfake đó vẫn tiếp tục được lan truyền trên nền tảng mạng xã hội này.

Thực tế là việc tạo ra âm thanh, hình ảnh của người khác bằng các công cụ AI không quá khó như nhiều người vẫn tưởng. Năm ngoái, công ty lớn nhất trong lĩnh vực là ElevenLabs đã có thể sao chép giọng nói của những người nổi tiếng và chính trị gia ngay cả sau khi họ đã đưa ra các chính sách và biện pháp bảo vệ chống lại hành vi đó.

Vào tháng 3, một đánh giá của Consumer Report về 6 sản phẩm sao chép giọng nói AI, bao gồm ElevenLabs, cũng phát hiện ra rằng không có biện pháp bảo vệ có ý nghĩa nào trong các sản phẩm đó có thể ngăn chặn mọi người sử dụng sai mục đích.

Âm thanh giả mạo giọng nói của phó tổng thống Mỹ được xem là “phần nổi của tảng băng chìm” về tình trạng mạo danh deepfake do AI tạo ra, đang gây ra những hiểu lầm nghiêm trọng trên TikTok và các nền tảng khác, tiếp tục gióng lên hồi chuông cảnh báo với người dùng internet về việc lan truyền những nội dung chưa được kiểm chứng chính thống.

Minh Châu

Link nội dung: https://dothi.reatimes.vn/toi-luot-pho-tong-thong-my-jd-vance-tro-thanh-nan-nhan-cua-deepfake-10359.html