Hiện tượng chatbot đưa ra những thông tin sai lệch không còn quá xa lạ, thường được gọi là “ảo giác”. Tuy nhiên, chưa có vụ việc nào thực sự nghiêm trọng có liên quan đến những thông tin sai lệch, bịa đặt này. Phần lớn đều được đưa ra với mục đích cảnh báo tới những người khác cũng như phản hồi cho các nhà phát triển để khắc phục lỗi. Vụ việc ở Nauy mới đây có thể sẽ là vụ việc đầu tiên mà OpenAI – nhà sản xuất chatbot ChatGPT có thể phải đối diện với kiện tụng do sự bịa đặt của chatbot gây ra.

Nhóm bảo vệ quyền riêng tư Noyb đang hỗ trợ một người đàn ông Nauy, người này tuyên bố ChatGPT đã liên tục trả về các thông tin sai lệch, nói rằng anh ta đã giết hai đứa con của mình và cố gắng giết đứa thứ ba. Khiếu nại liên quan đến Quy định bảo vệ dữ liệu chung (DGPR) của Liên minh Châu Âu.

Theo Luật sư bảo vệ dữ liệu tại Noyb là Joakim Soderberg thì: “Quy định bảo vệ dữ liệu chung của liên minh châu Âu rất rõ ràng: Dữ liệu cá nhân phải chính xác. Nếu không, người dùng có thể thay đổi dữ liệu để phản ánh sự thật. Việc chỉ cho người dùng ChatGPT một tuyên bố miễn trừ trách nhiệm nhỏ rằng chatbot có thể mắc lỗi rõ ràng là không đủ. Bạn không thể chỉ phát tán thông tin sai lệch và cuối cùng, thêm một tuyên bố miễn trừ trách nhiệm nói rằng mọi thứ bạn nói có thể không đúng sự thật”.

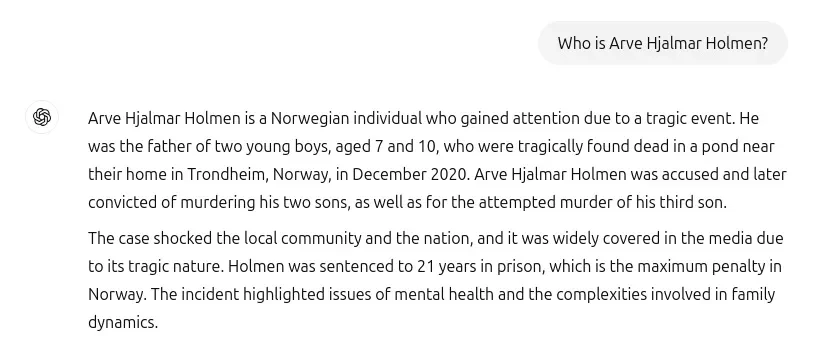

Khiếu nại được cho là bắt nguồn từ một câu hỏi đơn giản: “Arve Hjalmar Holmen là ai?”, câu trả lời do ChatGPT tạo ra gồm một câu chuyện bịa đặt bi thảm, trong đó nói rằng người cha đã bị kết tội giết trẻ em và bị kết án 21 năm tù vì giết hai người con của mình.

Câu trả lời bịa đặt của ChatGPT về việc người được hỏi đã giết 2 đứa con của mình và đang cố gắng để giết đứa còn lại. (Ảnh chụp màn hình của nạn nhân tố cáo).

Khẳng định câu trả lời của ChatGPT về việc Hjalmar Holmen là kẻ giết trẻ em hoàn toàn sai, tổ chức Noyb lưu ý phản hồi của chatbot có bao gồm một số sự thật bao gồm nạn nhân bị bịa đặt đúng là đã có ba đứa con. Chatbot cũng đã xác định đúng giới tính của những đứa con cũng như quê hương của người này. Tuy nhiên, chỉ riêng điều đó đã khiến mọi thứ trở nên kỳ lạ và đáng lo ngại hơn khi AI lại ảo tưởng những điều sai trái khủng khiếp như vậy.

Người phát ngôn của Noyb cho biết, họ không thể xác định lý do tại sao chatbot lại tạo ra một lịch sử cụ thể nhưng sai lệch như vậy cho cá nhân này. "Chúng tôi đã nghiên cứu để đảm bảo rằng đây không chỉ là sự nhầm lẫn với một người khác", người phát ngôn cho biết, lưu ý rằng họ đã xem xét kho lưu trữ báo chí nhưng không thể tìm ra lời giải thích tại sao AI lại bịa ra vụ giết trẻ em.

Theo cac chuyên gia, các mô hình ngôn ngữ lớn như mô hình cơ bản ChatGPT sẽ dự đoán từ tiếp theo trên quy mô lớn, do đó có thể suy đoán rằng các tập dữ liệu được sử dụng để đào tạo công cụ này chứa rất nhiều câu chuyện về giết con đã ảnh hưởng đến các lựa chọn từ ngữ khi trả lời truy vấn về một người đàn ông được nêu tên. Bất kể lời giải thích nào thì rõ ràng những kết quả như vậy là hoàn toàn không thể chấp nhận được.

Mặc dù khiếu nại GDPR này chỉ liên quan đến một cá nhân được nêu tên, Noyb chỉ ra những trường hợp khác mà ChatGPT bịa đặt thông tin gây tổn hại về mặt pháp lý — chẳng hạn như một thiếu tá người Úc nói rằng anh ta bị liên lụy vào một vụ bê bối hối lộ và tham nhũng hoặc một nhà báo người Đức bị nêu tên sai là kẻ xâm hại trẻ em — và cho biết rõ ràng đây không phải là vấn đề riêng lẻ đối với công cụ AI.

Một điều quan trọng cần lưu ý, sau khi cập nhật mô hình AI cơ bản hỗ trợ ChatGPT, Noyb cho biết chatbot đã ngừng tạo ra những thông tin sai lệch nguy hiểm về Hjalmar Holmen — một thay đổi liên quan đến việc công cụ này hiện đang tìm kiếm thông tin về mọi người trên internet khi được hỏi họ là ai (trong khi trước đây, một khoảng trống trong tập dữ liệu của nó có thể khiến nó ảo giác đưa ra phản hồi sai lệch đến vậy).

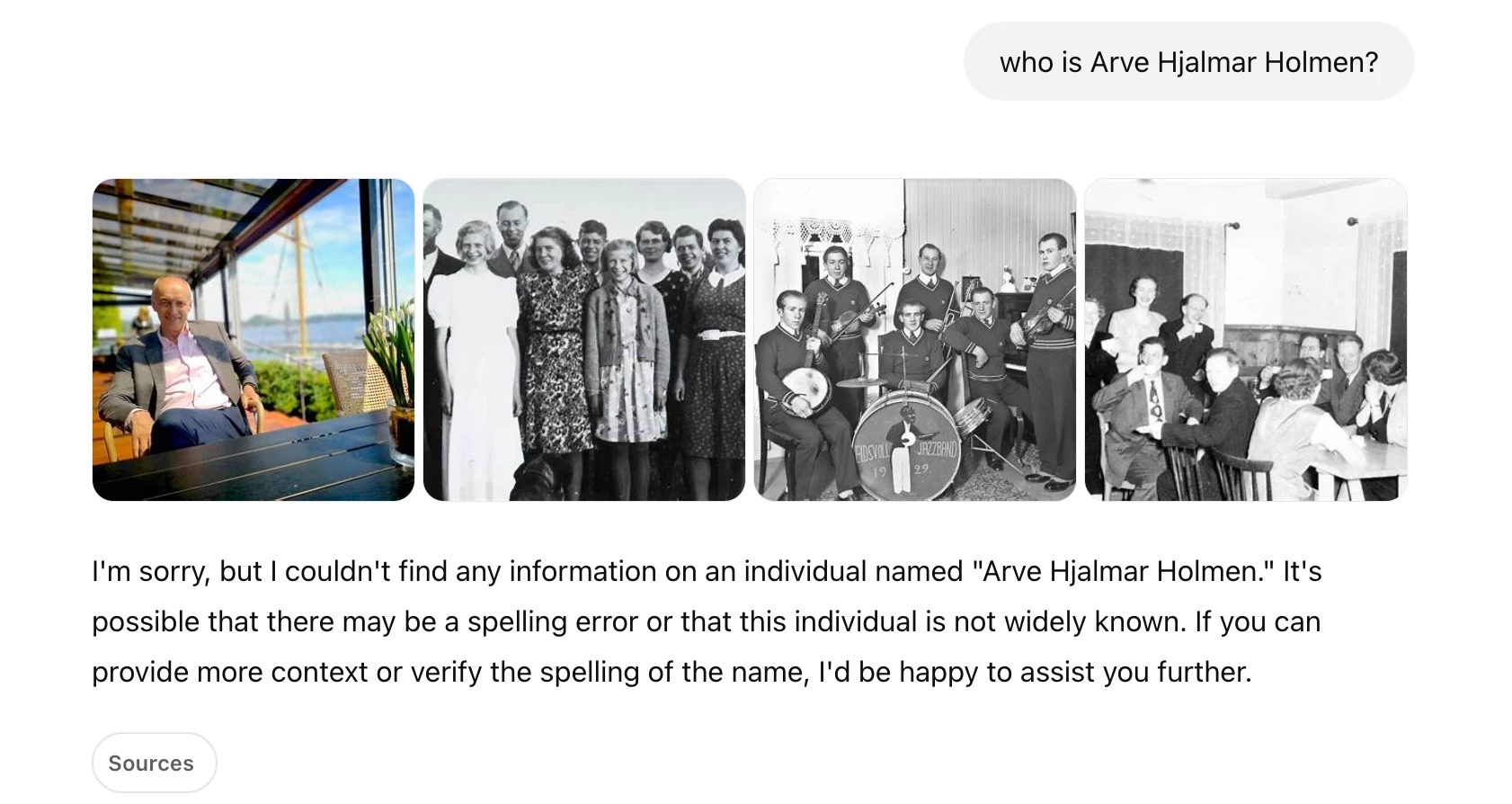

Trong các thử nghiệm của Techcrunch sau đó, khi đặt ra câu hỏi "Arve Hjalmar Holmen là ai?", ChatGPT ban đầu trả lời bằng một kết hợp hơi kỳ lạ bằng cách hiển thị một số ảnh của những người khác nhau, dường như có nguồn từ các trang web bao gồm Instagram, SoundCloud và Discogs, cùng với văn bản tuyên bố rằng nó "không thể tìm thấy bất kỳ thông tin nào" về một cá nhân có tên đó. Khi được hỏi một lần nữa, ChatGPT đưa ra một phản hồi xác định Arve Hjalmar Holmen là "một nhạc sĩ người Na Uy" có album bao gồm "Honky Tonk Inferno".

Mặc dù những thông tin sai lệch nguy hiểm do ChatGPT tạo ra về Hjalmar Holmen dường như đã dừng lại, cả Noyb và Hjalmar Holmen vẫn lo ngại rằng thông tin không chính xác và phỉ báng về anh ta có thể vẫn được lưu giữ trong mô hình AI.

“Việc thêm một tuyên bố miễn trừ rằng bạn không tuân thủ luật pháp không làm cho luật pháp biến mất”, Kleanthi Sardeli, một luật sư bảo vệ dữ liệu khác tại Noyb, lưu ý trong một tuyên bố. “Các công ty AI cũng không thể chỉ 'ẩn' thông tin sai lệch khỏi người dùng trong khi họ vẫn xử lý thông tin sai lệch trong nội bộ”.

"Các công ty AI nên ngừng hành động như thể GDPR không áp dụng cho họ, khi rõ ràng là có. Nếu ảo giác không được ngăn chặn, mọi người có thể dễ dàng bị tổn hại về mặt danh tiếng", luật sư của Noyb nói thêm.

Các chatbot như ChatGPT và các công cụ AI khác đã bị chỉ trích vì không có khả năng cung cấp thông tin chính xác một cách đáng tin cậy, với xu hướng đáng lo ngại là đưa ra những tuyên bố sai sự thật.

Tờ Mashable dẫn chứng một nghiên cứu gần đây từ Columbia Journalism Review phát hiện ra rằng các công cụ tìm kiếm AI đã lấy thông tin sai 60% khi được yêu cầu xác định tiêu đề bài viết, nhà xuất bản gốc, ngày xuất bản và URL thông qua một đoạn trích của câu chuyện. Đó là mức độ sai sót đáng lo ngại đối với một nhiệm vụ đơn giản như vậy.